Le dérushage est une étape qui se situe entre le tournage et le montage. Comme son nom l'indique, le dérushage consiste à partir des rushes bruts rassemblés sur un support numérique (carte SD, disque SSD, etc), à sélectionner les séquences qui seront utilisées lors du montage.

Nous allons donc visionner tous les plans et retenir ceux qui semblent pertinents avec le propos du sujet et les besoins de la narration. Ces plans sont ensuite triés, commentés à l'aide de métadonnées et classés selon leur numéro de séquence, le plan, leur numéro de la prise et leur timecode.

Les méthodes de travail peuvent varier selon qu'il y a eu recours ou pas aux services d'une scripte.

Le dérushage est une étape fondamentale et rigoureuse qui conditionne la suite du projet et facilite grandement le travail du monteur. Il permet en outre en éliminant les mauvaises prises de générer des économies en optimisant les volumes de stockage, car le stockage peut coûter cher si l'on n'y prend pas garde, surtout avec la redondance.

Il n'est pas nécessaire que vous conserviez sur vos serveurs l'intégralité de vos prises.

Absolument pas, il est possible en parallèle (ou pas) du dérushage de réaliser d'autres opérations élémentaires et indispensables sur les images, notamment une première phase d'étalonnage avant d'envoyer les fichiers au montage.

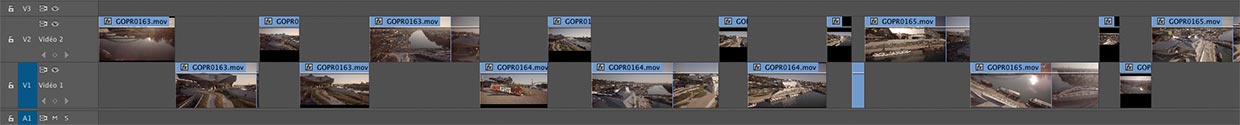

Timeline de dérushage sous Adobe Premiere Pro CC

D'autre part, si la qualité des images terrestres est généralement relativement homogène avec des techniques et du matériel éprouvé, il en va souvent autrement par exemple pour les caméras embarquées ou les images aériennes de drones lorsqu'elles sont réalisées avec des capteurs moins performants pour répondre aux impératifs de poids (autonomie, législation, etc).

Lorsque ces images sont réalisées dans des conditions difficiles ou par des opérateurs mal équipés, il n'est pas rare que les images souffrent de tremblements, de déformations en barillet (le fameux effet fisheye), d'un manque cruel de dynamique ou d'une color science approximative.

Evidemment, il est préférable de ne pas rencontrer ces cas de figure, mais lorsque cela se produit (dans des limites acceptables), ce n'est pas forcément rédhibitoire.

Les technologies actuelles permettent une stabilisation logicielle efficace (moyennant un crop dans l'image, tolérable ou non en fonction du format de sortie) et le redressement des déformations et autres perspectives. Toutefois, ces post-traitements demandent d'importantes ressources informatiques avec des puissances de calcul élevées qui exigent des cartes graphiques performantes équipées des technologies CUDA, OPEN CL ou Metal.

En particulier sur des fichiers volumineux en 4K qui deviennent courants, par exemple issus des caméras GoPro largement utilisées dans les domaines de l'aérien ou des caméras embarquées. Dès lors, ces traitements en volume ne sont plus vraiment possibles avec des moyens informatiques classiques tels qu'un ordinateur portable.

De la même manière, les images issues de matériels légers et souvent bon marchés sont enregistrées puis compressées au format MP4, avec le codec H264. Ce traitement processeur par algorithmes (calcul matriciel) des caméras se nomme l'échantillonnage vidéo et il correspond à un besoin de réduire le poids du signal.

Il présente l'avantage de limiter les débits et volumes de données pour permettre l'enregistrement des images sur des cartes mémoire flash de type (micro) SD, mais il a aussi un inconvénient majeur : la compression supprime une partie des données contenues dans les images ce qui rend le travail de postproduction délicat.

Pour cela, la compression convertit le triplet Rouge, Vert, Bleu (RVB) en un triplet Luminance, Différence Bleu, Différence Rouge, dans l'espace de couleurs YCbCr, en utilisant le canal vert comme niveau de référence.

Un signal vidéo se compose comme suit de plusieurs signaux :

Sans rentrer dans le détail, vous devez savoir que l'oeil humain est très sensible aux variations de luminance (bâtonnets) mais beaucoup moins aux variations de chrominance (cônes). Par conséquent, les mécanismes de compression suppriment une partie plus ou moins importante des informations de chrominance (l'échantillonnage est exprimé via les ratios luma/chroma 4:4:4 - 4:2:2 - 4:1:1 - etc), différence peu ou pas visible à l'oeil nu.

En revanche, lors de l'étalonnage des images, les logiciels ne s'y trompent pas et ils ont besoin de toutes les informations pour travailler correctement, à défaut de quoi vous verrez très rapidement apparaître des aberrations chromatiques (bruit numérique, postérisation, etc).

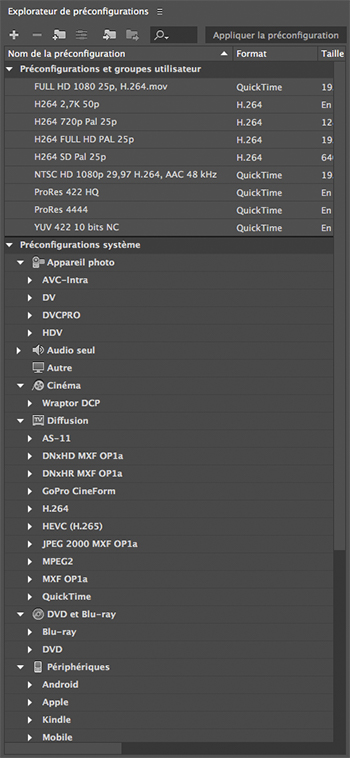

Une étape préalable au traitement des fichiers encodés en H264 consiste en leur décompression vers des formats de travail plus performants tels que le ProRes par exemple. Cette phase de décompression permet de retrouver par calcul de déduction (luminance, différence bleu, différence rouge) une partie des informations manquantes dans les Verts pour faciliter le travail de postproduction qui n'en sera que meilleur.

Ces phases de décompression peuvent-être très longues pour les gros volumes de données avec des fichiers lourds, ce qui nécessite des outils adaptés. Un des effets secondaires est l'explosion du poids des fichiers et donc du coût de stockage.

Le frame rate (FPS pour Frame Per Second ou IPS en français pour Images Par Secondes) est une unité de mesure qui correspond au nombre d'images affichées en une seconde par un dispositif.

Au cinéma, le frame rate standard est de 24 fps et à la télévision de 25 fps en Europe (PAL) et 29,97 fps au Japon et aux Etats-Unis (NTSC).

Toutefois, ce frame rate peut varier pour réaliser des ralentis ou des travellings rapides fluides. Dans ce cas, il convient de filmer avec un hight frame rate et certains films récents ont pleinement utilisé cette technologie, notamment « Le Hobbit » de Peter Jackson.

Théoriquement, il est recommandé de filmer avec le frame rate qui correspond au format de sortie d'un projet, mais parfois, il est nécessaire en post-production de modifier la vitesse, par exemple pour exporter aux US un film réalisé pour le marché Européen ou par faire matcher des images qui proviennent de différentes caméras (souvent nécessaire dans les documentaires qui font appel à des images d'archive).

Or, ces manipulation de frame rate sont délicates et il faut-être prudent. Le risque est qu'il soit mal géré et que les logiciels utilisés se contentent par exemple de supprimer des images clé, créant un effet saccadé, auquel cas votre film ressemblera à un mauvais Timelapse. En outre, modifier le frame rate peut influer sur la vitesse du film ou sur sa durée, selon la manière dont sont opérés ces changements.

Nous vous proposons de réaliser ces traitements dans notre studio de postproduction qui dispose des équipements les plus performants.